人工知能(AI)の台頭に伴い、AIのための セキュア・バイ・デザイン が重要なパラダイムとして浮上しています。 AIは、ヘルスケアや金融から開発者、自律走行車やスマートシティまで、私たちの生活のあらゆる側面に統合されており、重要なインフラストラクチャへのAIの統合により、脅威を理解し、対処するために迅速に行動することが求められています。

AIのセキュア・バイ・デザインの必要性

AIが重要なインフラストラクチャに急速に統合されたことで、潜在的な脅威を理解し、対処する必要性が加速しています。 セキュリティ対策は、AI製品に最初から組み込まれ、モデルの進化に合わせて進化する必要があります。 このプロアクティブなアプローチにより、AIシステムは新たな脅威に対する回復力を持ち、新たな課題が発生したときに適応できるようになります。 この記事では、開発者業界とヘルスケア業界という2つの二極化した例を探っていきます。

AI における脅威モデリングの複雑さ

AIは、正確な脅威モデルに取り組む際に新たな課題や難問をもたらします。 データが体系的にプログラムできる単純な編集および検証チェックを持つ状態に達する前に、AI検証チェックはシステムとともに学習し、データの操作、破損、および抽出に焦点を当てる必要があります。

- データポイズニング: データポイズニングは、システムで使用されるデータの整合性が損なわれる可能性のあるAIの重大なリスクです。 これは意図的または意図せずに発生する可能性があり、深刻な結果につながる可能性があります。 例えば、AIシステムにおける偏見や差別は、デトロイトで顔認識の誤認による男性の不 当逮捕 など、すでに問題を引き起こしています。 このようなインシデントは、偏りのないモデルと多様なデータセットの重要性を浮き彫りにしています。 バイアスをテストし、開発プロセスに多様な労働力を関与させることは、これらのリスクを軽減するための重要なステップです。

例えば、医療分野では、バイアスは検出しやすいかもしれません。 性別、人種などの領域に基づいてデータフィールドを調べることができます。

開発ツールでは、バイアスはそれほど明確ではありません。 バイアスは、Clojureなどの特定の開発言語の過小評価から生じる可能性があります。 バイアスは、コーディングの好みや教えの地域差に基づくコードサンプルから生じることもあります。 開発者ツールでは、このバイアスを検出するための情報が得られない可能性があります。 IPアドレスは、その人が現在住んでいる場所に関する情報を提供する場合がありますが、彼らが育った場所やコーディングを学んだ場所に関する情報は提供しません。 したがって、バイアスの検出はより困難になります。

- データ操作: 攻撃者は、悪意を持ってデータセットを操作し、AIシステムの動作を変更することができます。

- プライバシーの侵害: 適切なデータ管理を行わないと、個人情報や機密情報が意図せずにシステムに導入され、プライバシー侵害につながる可能性があります。 このようなシナリオを防ぐために、強力なデータ管理プラクティスを確立することが重要です。

- 回避と乱用: 悪意のあるアクターは、入力を変更してAIシステムの応答を操作しようとし、それによってAIシステムの完全性を損なう可能性があります。 また、開発者が予想していなかった方法でAIシステムが悪用される可能性もあります。 たとえば、AIによるなりすまし詐欺は、従業員が会社のCFOになりすました詐欺師に2600万ドルを送金したケースなど、多額の金銭的損失をもたらしています。

これらの例は、「不良データ」を特定して軽減し、AIシステムのセキュリティと信頼性を確保するために、AIデータライフサイクルのさまざまなポイントで制御する必要性を強調しています。

AI で Secure by Design を実装するための主要な領域

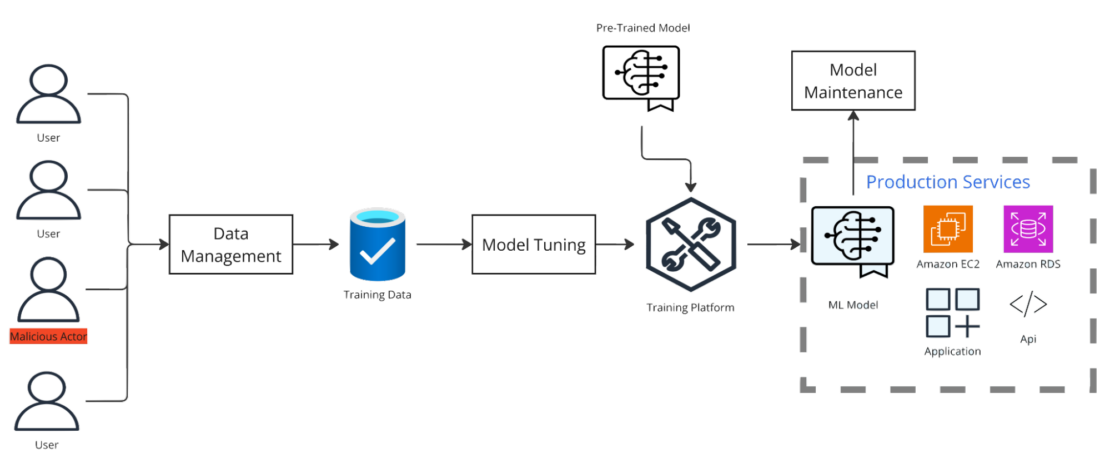

AIシステムを効果的に保護するには、次の3つの主要な領域で制御を実装することが不可欠です(図 1)。

1。 データ管理

データ管理の鍵は、モデルのトレーニング、機密データフィールドの特定、不要なデータの収集を防ぐために収集する必要があるデータを理解することです。 データ管理には、不要なデータや不良データの収集を防ぐための正しいチェックとバランスを確保することも含まれます。

医療分野では、機密データフィールドを簡単に特定できます。 診療所では、運転免許証、パスポート、社会保障番号などの国民IDを収集することがよくあります。 また、生年月日、人種、その他多くの機密データフィールドも収集します。 このツールが、医師が症状に基づいて潜在的な状態をより迅速に特定できるようにすることを目的としている場合、匿名化されたデータが必要になりますが、年齢や人種などの特定の要素を収集する必要があります。 各国の識別子を収集する必要はありません。

開発者ツールでは、機密データが明確に定義されていない場合があります。 たとえば、環境変数を使用して、シークレットを渡したり、開発者からの画像名などの機密情報を AI ツールに渡したりできます。 あなたが疑わないフィールドには秘密があるかもしれません。 このシナリオでのデータ管理には、機密データが存在する可能性のあるフィールドの収集をブロックすることや、ツールに組み込まれた機密データをスクラブしてデータがモデルに入らないようにするメカニズムがあることの確認が含まれます。

データ管理には、次のものを含める必要があります。

- 予期しないデータのチェックの実装: 医療では、このプロセスには、無関係または有害な情報の収集を防ぐために、特定のデータ フィールドの "許可" リストが含まれる場合があります。 開発者ツールでは、脆弱性を引き起こす可能性のあるサニタイズされていない入力など、悪意のあるコードでモデルがトレーニングされていないことを確認することが重要です。

- ユーザーとその活動の正当性を評価する: ヘルスケアツールでは、この手順はユーザーがライセンスを持つ専門家であることを確認することを意味しますが、開発者ツールでは、ボットアカウントやスパムユーザーの影響を検出して軽減することが含まれる場合があります。

- 継続的なデータ監査: このプロセスにより、予期しないデータが収集されず、データ チェックが必要に応じて更新されます。

2。 アラートと監視

AIでは、データモデルの健全性を確保するために、アラートと監視が不可欠です。 コントロールは、異常なアクティビティや悪意のあるアクティビティを検出するために、適応性と構成可能の両方を備えている必要があります。 AIシステムが成長し、適応するにつれて、制御も成長して適応する必要があります。 データのしきい値を設定し、可能な場合は調整を自動化し、必要に応じて手動レビューを実施します。

ヘルスケアAIツールでは、新しいデータが表示される前にしきい値を設定して、その精度を確保することができます。 たとえば、患者が糖尿病に関連していると思われる新しい症状を報告し始めた場合、全患者の一定の割合 (15%) によって報告されるまで、これを医師に報告することはできません。

開発者ツールでは、これには、他のユーザーのプロンプトとして新しいコードをモデルに組み込むタイミングを決定することが含まれる場合があります。 このモデルでは、ユーザーのクエリとフィードバックをログに記録して分析し、未処理または不適切に処理された要求を追跡し、新しい使用パターンを検出できる必要があります。 未処理のプロンプトが高頻度で発生する場合はデータを分析する必要があります。また、アラートを生成して、追加のデータ セットがレビューされ、モデルに追加されるようにする必要があります。

3。 モデルのチューニングとメンテナンス

AIツールの作成者は、AIモデルを定期的に見直して調整し、安全性を確保する必要があります。 これには、予期しないデータの監視、必要に応じてアルゴリズムの調整、機密データが適切にスクラブまたは編集されていることを確認することが含まれます。

ヘルスケアの場合、モデルのチューニングはより集中的になる可能性があります。 結果は、患者の状態が世界中で確立された他のベースラインと一致していることを確認するために、公開された医学研究と比較することができます。 また、医療過誤の請求が報告された医師や医師免許が取り消された医師がシステムからスクラブされ、侵害された可能性のあるデータセットがモデルに影響を与えていないことを確認するためにも監査を実施する必要があります。

開発者ツールでは、モデルのチューニングは大きく異なります。 ハイパーパラメータの最適化は、グリッド検索、ランダム検索、ベイジアン検索などの手法を使用して検討できます。 データのサブセットを研究することができます。たとえば、最新のデータを定期的にレビューして、新しいプログラミング言語、フレームワーク、またはコーディング方法を探すことができます。

モデルのチューニングとメンテナンスには、次のものを含める必要があります。

- データ監査を実施して、データの整合性を確保し、不要なデータが誤って収集されていないことを確認します。

- 「許可」リストと「拒否」リストを更新する必要があるかどうかを確認します。

- アルゴリズムのアラートを定期的に監査および監視して、調整が必要かどうかを判断します。これらのパラメーターを調整するときは、ユーザーベースの母集団とモデルのトレーニング方法を考慮してください。

- ソースが侵害された場合に削除するためにデータセットを分離するための制御が整っていることを確認します。不要な機密データを提供せずにソースを識別できる一意の識別子を検討してください。

- データ モデルを定期的にバックアップして、ソースが侵害された場合にデータを大量に失うことなく以前のバージョンに戻せるようにします。

AIセキュリティはデザインから始まる

セキュリティは、AI開発の基本的な側面であり、後付けであってはなりません。 データフィールドを事前に特定し、徹底的なAI脅威モデリングを実施し、堅牢なデータ管理制御を実装し、モデルを継続的に調整および保守することで、組織は設計上安全なAIシステムを構築できます。

このアプローチにより、潜在的な脅威から保護し、AI システムがユーザー ベースとともに進化するにつれて、信頼性と信頼性を維持し、規制要件に準拠し続けることができます。

さらに詳しく

- セキュリティシリーズをお読みください。

- Docker Newsletter を購読してください。

- Docker デスクトップの最新リリースを入手します。

- 質問がありますか? Docker コミュニティがお手伝いします。

- ドッカーは初めてですか? 始めましょう。